简介:

简介:

吕锡香,博士,教授,西安电子科技大学信息安全专业博士研究生导师,获学校首届“菁英人才计划(创新型)”支持,信息安全专业国家级教学团队成员;2001年获西安电子科技大学工学学士学位,2007年获西安电子科技大学密码学工学博士学位;研究领域主要包括深度学习与安全、天地一体化网络安全、云安全等;在信息安全国际主流期刊和重要会议上发表和录用论文三十余篇,其中包括CCF信息安全A类期刊IEEE TDSC、IEEE TIFS、IEEE/ACM TON以及深度学习国际顶级会议NIPS、ICML、ICLR等;授权发明专利十余项。

联系方式:

通信地址:西安电子科技大学网络与信息安全学院02-0093信箱,邮编 710071

办公地点:南校区网络安全创新研究大楼B407

办公电话:029-81891873

吕锡香 教授

网络与信息安全学院

1. 深度学习与安全

2. 天地一体化网络安全

3. 云安全

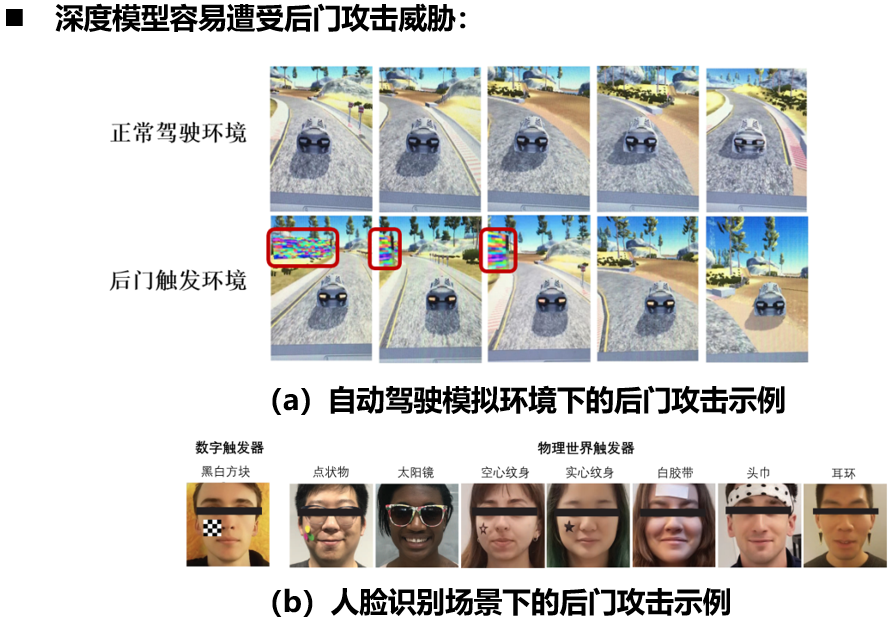

目前主要研究的问题之一:深度学习模型安全问题

目前主要研究的问题之一:深度学习模型安全问题

在深度学习模型后门防御上的研究成果:

在深度学习模型后门防御上的研究成果:

(1)发现了深度学习的一个重要问题,即深度学习模型在后门数据上的学习速率明显大于在正常数据上的学习速率,且攻击越强模型在后门数据上收敛越快。基于这一新的发现,我们提出了“反后门学习”(Anti-Backdoor Learning, ABL)的普适性后门防御方法,使得模型在训练阶段自动屏蔽后门,给出了在毒化数据上训练可信良性模型的有效方法,具有通用性,不受攻击方式限制,获得了模型层面后门防御的良好效果,成果发表在人工智能国际顶会NeurIPS 2021上,目前引用近200次。→ Yige Li, Xixiang Lyu, Nodens Koren, Lingjuan Lyu, Bo Li, Xingjun Ma, Anti-Backdoor Learning: Training Clean Models on Poisoned Data, NeurIPS 2021.

(2)发现了后门模型的一个重要特征,即在嵌入了后门的深度神经网络模型中,其后门区域在attention maps中显著突出。基于这一发现,我们提出了神经注意力蒸馏方法(Neuron Attention Distillation, NAD)并构建了一个基于NAD的普适性后门攻击防御框架,NAD利用教师网络在少量干净数据子集上指导后门学生网络的微调,以使学生网络的中间层注意力激活与教师网络的注意力激活保持一致,从而能够在不降低模型性能的情况下有效清除后门模型中的后门触发。该方法具有通用性,不受攻击方式限制,对目前已发现的几类后门攻击都有很好的后门清除效果,是一种简单而有效的后门模型净化方法。相关研究成果发表在人工智能国际顶会ICLR2021上,目前引用300余次。→ Yige Li, Xixiang Lyu, Nodens Koren, Lingjuan Lyu, Bo Li, Xingjun Ma, Neural Attention Distillation: Erasing Backdoor Triggers from Deep Neural Networks, ICLR 2021.

(3)针对目前深度神经网络后门防御中难以精准识别和定位后门相关神经元从而导致盲目剪枝的问题,提出重构神经元剪枝(RNP)后门模型净化方法,先通过神经元级别的反学习从模型内部抑制良性神经元功能,再通过滤波器级别的再恢复重新修复干净神经元的功能,性能优于当前的最先进的后门移除方法。RNP解决了后门防御中无法精确定位后门神经元的难题,为模型净化和模型增强提供了全新的思路。相关研究成果发表在人工智能国际顶会ICML2023上,目前引用10余次。→Yige Li, Xixiang Lyu, Xingjun Ma, Nodens Koren, Lingjuan Lyu, Bo Li, Yu-Gang Jiang. Reconstructive Neuron Pruning for Backdoor Defense, ICML2023.

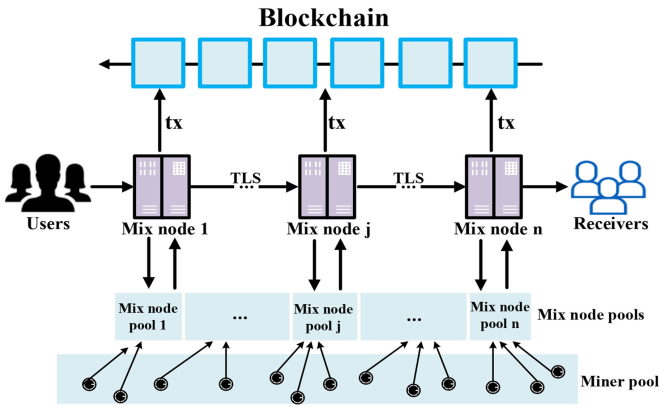

![]() 目前主要研究的问题之二:动态自重构匿名传输网络设计

目前主要研究的问题之二:动态自重构匿名传输网络设计

![]() 在动态自重构匿名传输网络设计上的研究成果:

在动态自重构匿名传输网络设计上的研究成果:

基于内生安全思想,优化了国际大密码学家David Chaum于2017年提出的cMix混淆网络。我们利用区块链共识机制设计了能够动态自重构的匿名通信混淆网络BCMIX,这种动态自重构的网络结构具有“测不准”的内生安全鲁棒性,能有效抵御网络测量和阻断攻击,能够提供高强度匿名的安全传输。该项研究成果发表于IEEE/ACM TNET。→ RenPeng Zou , Xixiang Lyu, Jing Ma, Bowen Zhang , Danfang Wu, BCMIX: A Blockchain-based Dynamic Self-reconfigurable Mixnet,IEEE/ACM Transactions on Networking, 2023.31(5):2222 - 2235.

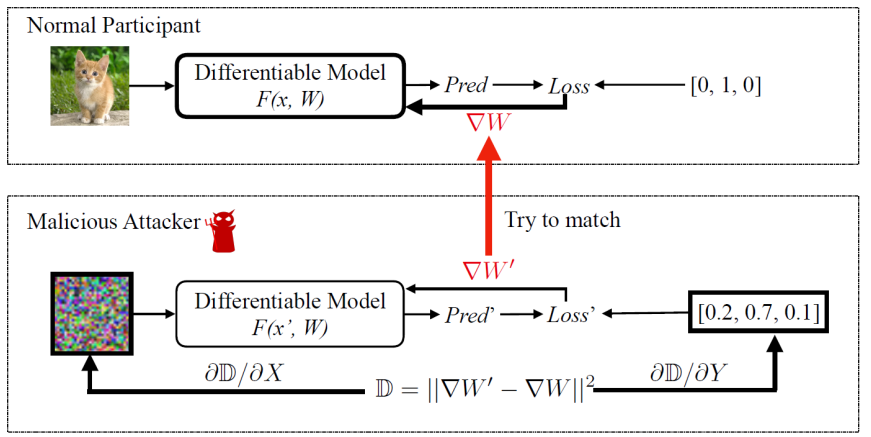

![]() 目前主要研究的问题之三:联邦学习安全问题

目前主要研究的问题之三:联邦学习安全问题

训练集推理攻击:

![]() 在联邦学习安全上的研究成果:

在联邦学习安全上的研究成果:

基于多密钥同态加密构造了面向联邦学习的高效率数据隐私保护方案,能同时抵御内部攻击和外部攻击,低功耗、低开销的优势使其可以适用于物联网和边缘网络。相关研究成果发表在中科院JCR一区国际期刊International Journal of Intelligent System 上,目前引用100余次。→ Jing Ma, Si-Ahmed Naas, Stephan Sigg, Xixiang Lyu, Privacy-Preserving Federated Learning based on Multi-key Homomorphic Encryption, International Journal of Intelligent System, 2022, 37:5880-5901.