一、视频图像建模、表示与学习

1.多尺度几何分析与图像稀疏表示

稀疏作为图像信号的先验特性,近年来得到了越来越多的关注和研究,而在众多信号处理的领域,稀疏表示也得到了更多的应用,为图像分析提供了有效的工具。传统方法通常处理的是二维图像,对于图像中的复杂结构,通常维数高,类型多,如何有效的表示这些高维奇异性,则成为目前国际研究的热点和难点问题。虽然传统的数据表示方法,如小波等,能有效表示图像,但存在高维奇异性逼近效率低、难以捕获复杂图像中方向信息等难点问题。

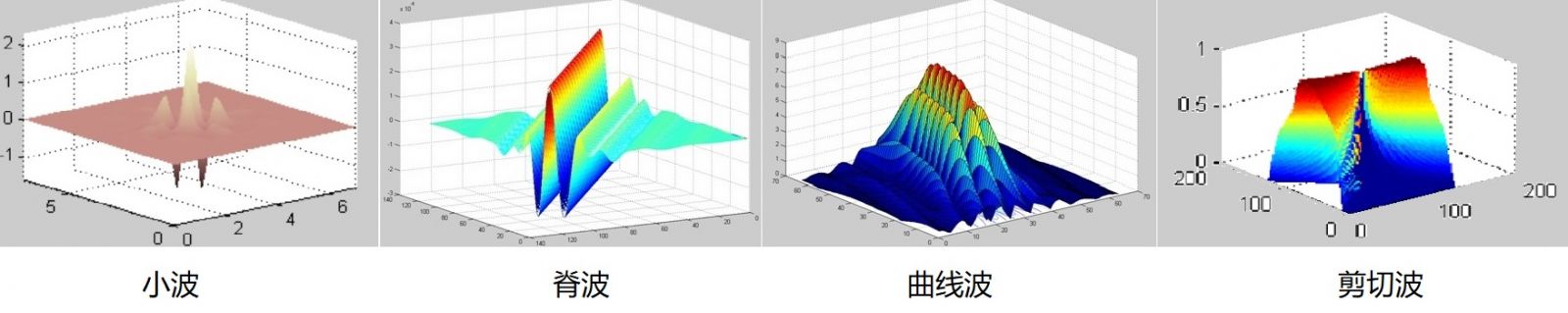

团队在国内较早开展了多尺度几何分析(Multiscale Geometric Analysis)研究,如小波(Wavelet),脊波(Ridgelet),曲线波(Curvelet),梳状波(Brushlet),轮廓波(Contourlet),楔形波(Wedgelet),子束波(Beamlet),条带波(Bandelet),方向波(Directionlet),剪切波(Shearlet)等等,利用函数的非线性逼近理论,在多尺度几何分析图像稀疏表示模型、图像高维奇异性感知与表达问题上取得了突破。针对图像的稀疏建模与表示问题,构造了各向异性的多尺度几何基函数,提出了相应的快速算法,为解决图像方向信息建模与分析提供了有效的理论和方法。针对图像高维奇异性感知与表达问题,提出了图像稀疏表示和特征提取的新方法,突破了复杂图像结构信息检测与提取的瓶颈。

图1 多尺度几何分析的方向基函数

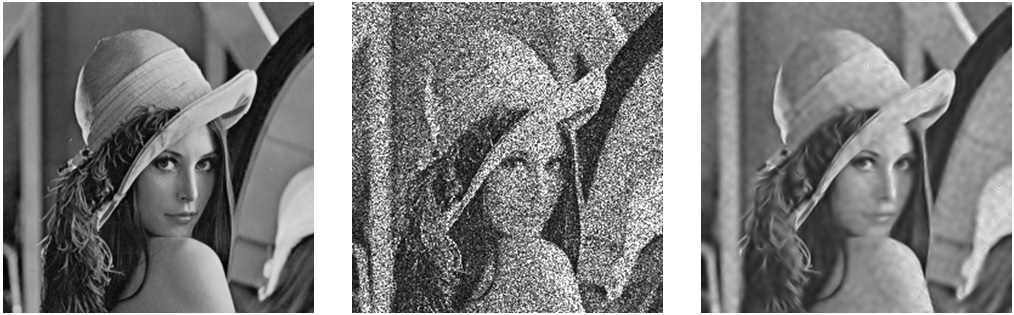

原像 四视幅度图 非下采样Shearlet变换去噪

图2 Lena图像(四视幅度)乘性相干斑去噪结果

2.类脑感知、学习与认知

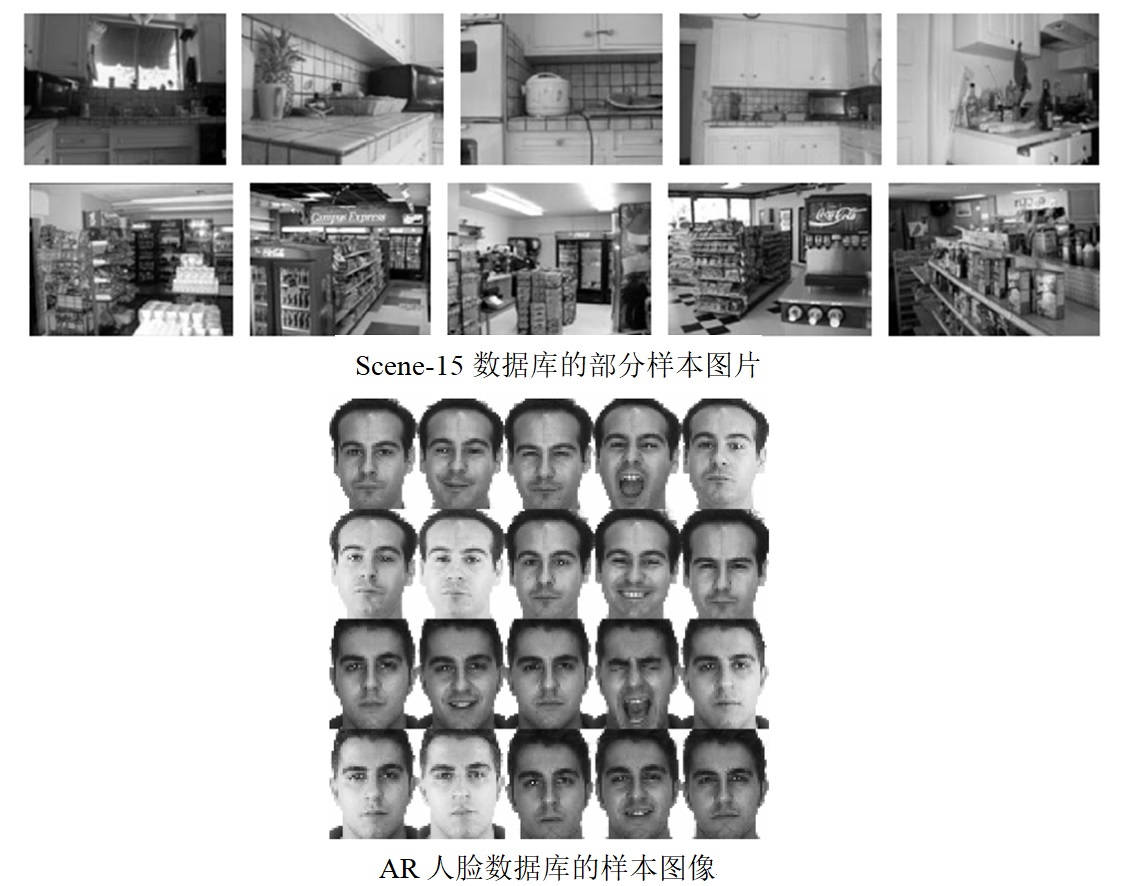

针对信息压缩的采样、表示学习与感知等基础理论,建立了类脑压缩表示学习与深度认知推理的框架;提出了基于半监督学习的联合稀疏恢复算法,实现了机器学习与稀疏优化理论的融合;提出了面向聚类任务的压缩采样学习与模糊稀疏子空间分割联合框架,缓解了高维空间内数据聚类复杂度高且可分性弱的核心瓶颈,从而降低了聚类误差;提出了基于生成式模型的分层结构化图像表示框架,通过对分层的隐变量利用结构稀疏与低秩先验建模,解决了数据域和特征域中类内差异成份与类间相似成份的表征问题,并能实现图像分类性能的显著提升;提出了非线性协同稀疏模型,解决了在合成稀疏模型中隐变量推断复杂度高且隐变量先验函数选择无法自适应于任务的问题,实现了任务驱动的先验正则函数快速判别式学习,并提高了隐变量推断与分类的效率。

图3 Scene-15图像库的分类精度为98.39%,AR人脸数据库的分类精度为99.43%

3.智能视频分析技术

智能视频分析技术是一种涉及图像处理、模式识别、人工智能等多个领域的智能分析技术。它能够对视频区域内出现的警戒区警戒线闯入、物品遗留或丢失、逆行、人群密度异常等异常情况进行分析,及时发出告警信息,并可根据对实时、历史视频的有效信息,对人、车、物、行为等进行结构化提取,并进行智能分析,实现特定目标的快速定位、查找、检测、识别、跟踪和检索。在工业生产现场、生活社区、安全要求敏感等场合,智能视频分析技术有重要应用价值,对维护国家及公共安全有现实意义。

针对复杂环境因素造成现有成像设备得到的视频出现严重的失真或模糊现象,研究了视频图像的优化处理如去雾、去噪、去模糊、夜间增强、超分辨重建等技术。针对视频大数据应用中,异常事件监测及预警的自动化、智能化、实时化等需求,研究了基于深度学习的目标检测、目标识别、目标跟踪、姿态检测、人群密度检测等算法,设计实现了具有异常跟踪检测、跌倒检测、奔跑检测、违禁区域闯入检测、打架检测、人群密度预警等功能的智能视频分析系统,极大的减少了安防所需的人力物力,提升了异常事件的处理效率。

图4 视频去雾技术

图5 视频夜间增强技术

图6 视频监控智能分析系统(实现了行人和车辆等的异常行为检测,如奔跑、闯入、跟踪、摔倒等等)

二、空天地一体化协同无人系统与群体智能

无人机与无人车是集群系统中最具有代表性的两种对象,通过无人机与无人车的合理配合,可以弥补单一类型对象的不足,有效提升协同作业效能。无人机与无人车协同在智能交通、灾后救援等多领域都具有广阔的应用前景,是异构机器人协同系统问题中的研究热点。通过多无人机与地面车辆的交互协同和信息融合,提供跨域感知能力,拓展地面侦察车辆信息获取的精度和维度,提升异构集群系统的态势感知效能。

团队研究了智能无人系统协同感知、认知和自主决策、群体智能学习理论与方法等、研究了自主避障、路径规划、目标检测与跟踪、高效定位与姿态估计等技术。建立了无人系统目标检测跟踪的深度学习方法,研制了视频图像目标检测跟踪系统,实现了无人机感知前端异常目标的检测识别、行为分析与事件检测,为任务决策提供智力辅助,提高决策水平,在无人机、无人驾驶、安防监控等领域具有广阔的前景。

图7 无人机实时视频目标识别与跟踪系统

图8 空天地一体化安防巡检系统

三、SAR图像理解与解译

1.SAR图像解译与目标识别

雷达的功能已从早期的目标探测(“千里眼”)演化为目标成像和目标解译。合成孔径雷达(SAR)技术从过去的单极化、单波段、固定入射角、单模式,已经迅速发展成为高分辨、多极化、多波段、多模式、多平台的成像雷达,同时干涉SAR、超宽带、多卫星群等技术也在不断涌现。这些大量新型SAR数据包含的信息越来越丰富,这些图像数据为目标检测和识别,及各种地面活动的监测提供了直接的手段。如何更为有效、全面的分析和利用这些数据集,实现高效的场景解译,从中发现规律,并寻找感兴趣的目标知识是当前SAR领域研究的关键问题。

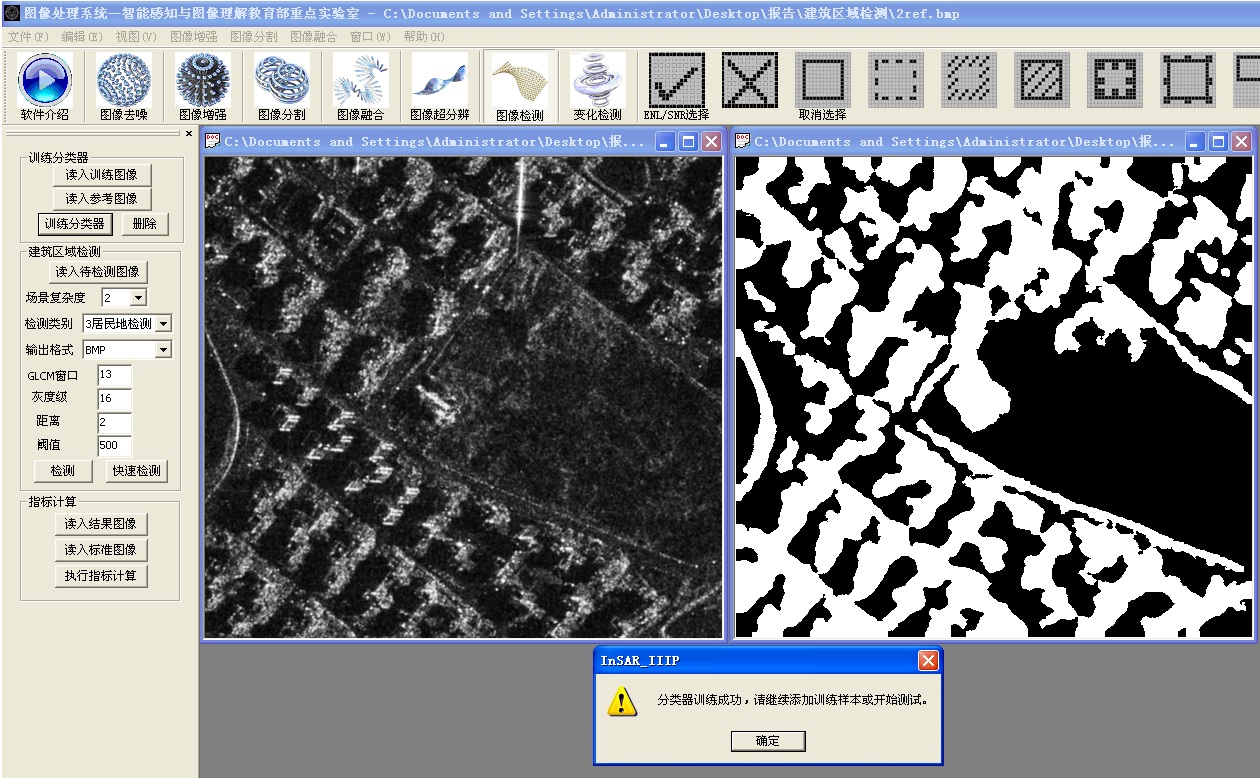

利用视觉感知、语义分析、深度学习、类脑智能、压缩感知等,在SAR数据采样与重建、SAR图像地物识别与动态监测、SAR目标检测与识别上取得了突破。针对SAR数据采样与重建问题,构造了基于重采样机制的SAR数据获取方法,建立了基于多变量压缩感知的图像重建方法,为解决非整数Nyquist采样率和随机观测下的SAR数据恢复提供了有效的信号处理理论和方法。针对SAR图像地物识别与动态监测问题,提出了SAR图像特征提取、语义分类与分割的新方法,为发展SAR在水监测、土地利用监测、测绘等的应用提供了技术保障。针对SAR目标检测与识别问题,提出了目标检测与识别的高效方法,推动了SAR图像解译、目标检测与识别技术的发展。

图9 SAR图像理解与解译系统

图10 SAR图像地物分类与变化检测系统

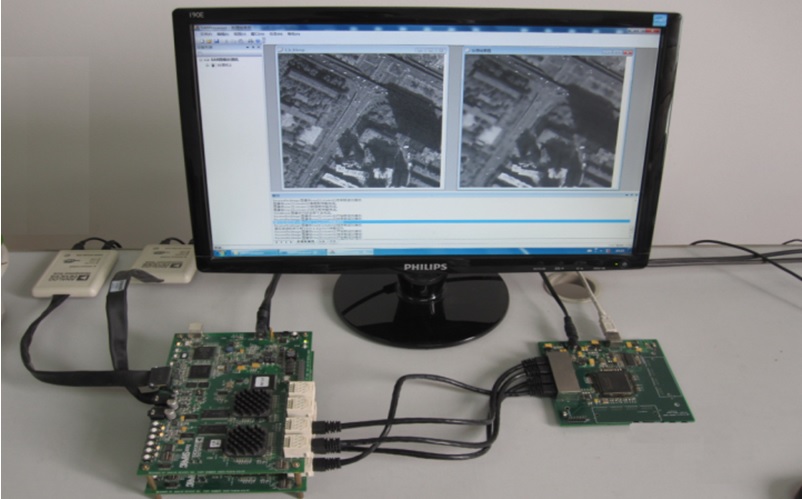

图11 基于ADSP-TS201的SAR图像并行处理系统

图12 基于深度学习的在轨SAR影像变化检测系统

2.类脑成像

现有的SAR成像仅能对整个场景成像,无法直接获得感兴趣“目标成像”的结果。现有雷达体制中采样、成像与解译单纯自底向上的过程无法根据任务、场景、对象与环境自适应进行调整,这种弱自适应能力带来的缺乏应变性不仅将造成雷达系统在实际任务中的信息冗余与资源浪费,而且基于Nyquist高速采样会造成硬件成本提高,信息提取效率降低,不利于后续的目标识别。

针对高分辨SAR目标成像与识别,提出了语义先验学习模型的面向目标的类脑成像框架,突破了奈奎斯特采样的瓶颈,实现了在少量观测视角的低采样回波数据条件下,感兴趣目标增强与背景杂波抑制的类脑成像方法,相比传统以及压缩感知等主流SAR算法,大幅度地提高了目标杂波比同时缓解了数据获取与高速采样的压力。下图13给出了MSTAR目标的实验结果,该实验数据采用美国国防高等研究计划署(DARPA)支持的MSTAR计划所公布的实测SAR地面静止目标数据,传感器为高分辨聚束式合成孔径雷达,分辨率为0.3m×0.3m,X波段,HH极化方式。

图13 不同MSTAR目标的“场景成像”(每幅左边一列)和“类脑成像”(每幅右边一列)结果对比

3.雷达脑

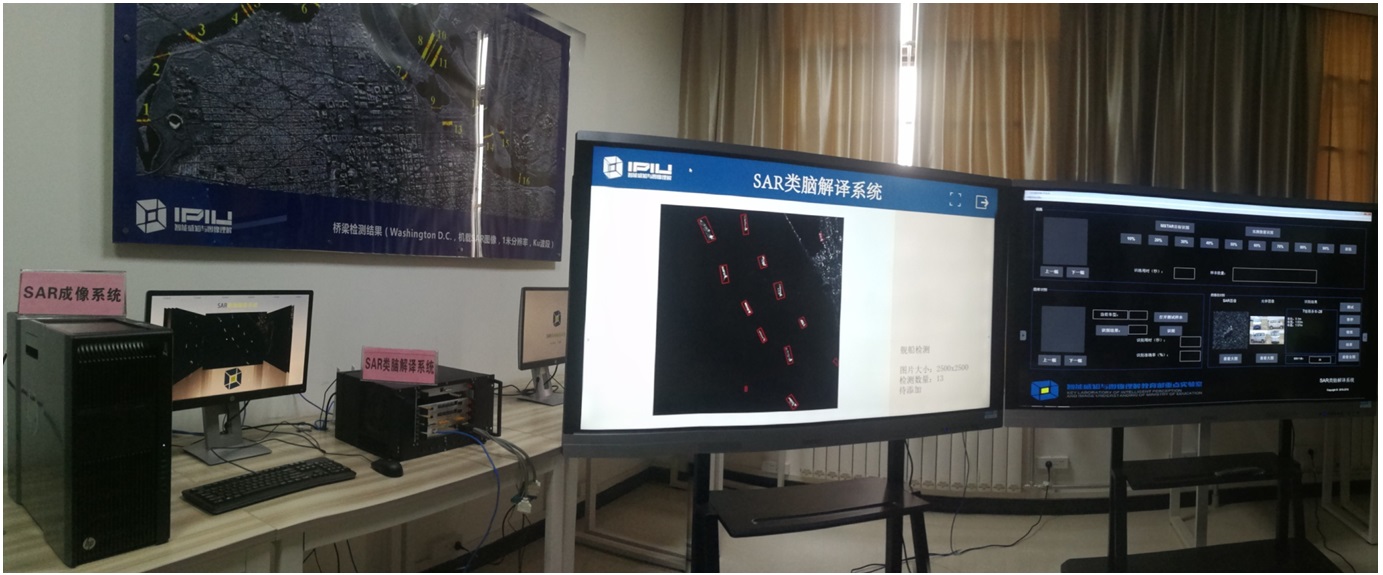

针对我国地形地貌多样、地物结构细碎等问题,在国产华为昇腾Atlas算力底座和MindSpore AI框架下,借鉴视觉感知机理和脑认知机理,建立了雷达遥感影像的类脑解译理论与方法,开展了以地物要素提取、图像配准及变化检测为核心的大规模影像智能解译技术研究,开发了雷达遥感预训练大模型,实现雷达遥感领域核心软硬件技术国产自主可控;研制了雷达遥感智能解译平台,满足我国通过雷达遥感技术对自然资源监管、生态文明建设、灾害应急管理、国土空间规划等的需求。

针对雷达影像高维、非结构化、目标繁多信息混杂等问题,借鉴人类大脑的信息感知机制和认知机理,以及多尺度视觉感知模型,提出了感知-认知-强化为一体的类脑智能计算新理论与新方法,成功采用FPGA/嵌入式优化设计并研制了轻量级深度卷积神经网路的雷达图像目标识别技术,实现了目标的检测与识别,在高分辨雷达影像实时计算方面取得了突破性进展,提高了信息处理的时效性,并通过软硬件协同处理实现了雷达图像的在轨实时处理,研制成功类脑雷达系统及原理样机,实现了雷达从“千里眼”到“雷达脑”的转变。

图14 类脑SAR解译系统

图15 雷达脑原理样机

图16 MSTAR实测目标的检测与识别结果

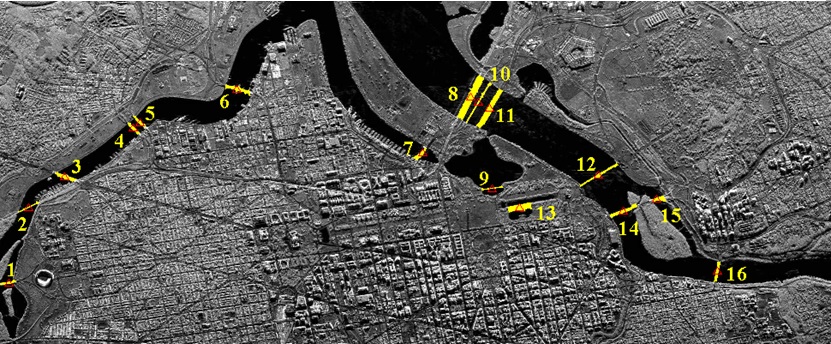

图17 桥梁检测结果(该实验数据采用美国桑迪亚国家实验室(Sandia)的机载SAR数据,分辨率为1米,Ku波段)

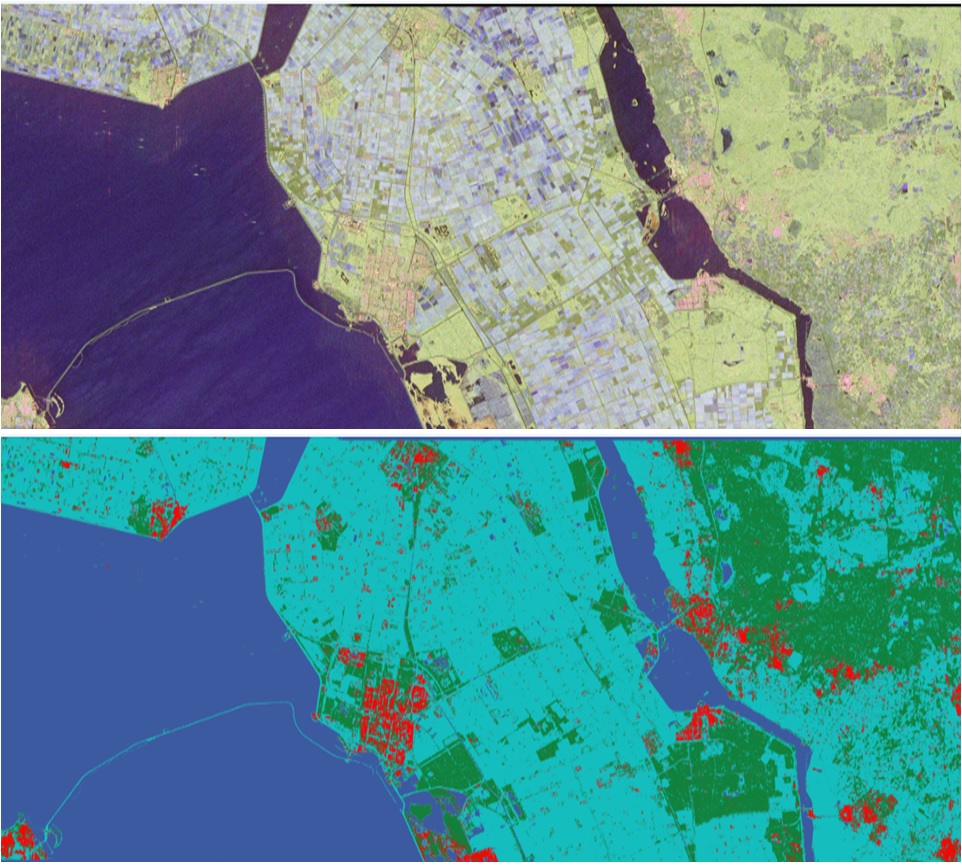

4.极化SAR地物分类和变化检测

相比于单极化SAR,极化SAR(Polarimetric SAR,PolSAR)一方面通过分析得到的全散射矩阵来推测地物目标的几何结构等细节特性以及地物目标的介电常数信息,另一方面通过选择合适的极化合成方式可以突出地物目标的分布区域,地物层次的变化。地物分类和变化检测是PolSAR图像理解与解译的一个重要任务之一,对于地质勘探,植被海洋监测与预警起了至关重要的作用。

团队针对当前极化SAR数据处理只关注极化散射特性,而没有考虑人类视觉感知特性的问题,利用视觉先验,将压缩感知理论和视觉注意理论相结合,提出高分辨极化SAR图像的稀疏模型与自适应学习字典构造方法,建立了极化SAR图像地物分类和变化检测。受大脑感知、学习表示与决策融合过程的启发,针对PolSAR不同模态的数据,构造了多模块的深层神经网络来感知不同模态下的特征表示,提高了极化SAR图像的分类效果。

图18 2008年4月, 荷兰Flevoland省Netherlands地区,50×25 Km范围, RADARSAT-2 C-Band模式拍摄,图像大小12944×2820, 分辨率10m×5m, 主要包含4类地物:森林、农田、水域和城区,分类正确率OA=98.3%

5.视频SAR运动目标检测、识别与跟踪

SAR地面运动目标检测和分析是利用SAR实现空间对地观测运用的一个主要方面,具有重要的战略作用。如何高效的检测出运动目标、确定目标运动参数及其位置并对运动目标成像是监视雷达的主要任务。利用SAR进行地面运动目标检测和成像都具有重要意义,是目前研究的热点。国内外对基于单通道、多通道、分布式小卫星等的雷达系统的动目标的检测和成像方法进行了深入研究。VideoSAR(视频SAR)是美国Sandia实验室在2003年提出的新型成像模式,通过对场景连续的高分辨率成像,实现对地面的动态观测,可获得运动目标的相关信息,并进行跟踪。由于运动目标在雷达视线上的径向运动速度的存在,其多普勒频率和它所处的杂波单元的多普勒频率是不同的,使得运动目标在成像时发生偏移和散焦,给SAR运动目标的检测、识别与跟踪带来了困难。

团队针对VideoSAR的成像特点,以智能化目标识别和跟踪应用需求为牵引,重点开展VideoSAR视觉目标自学习理论、面向VideoSAR弱小目标的机器学习与认知方法、面向VideoSAR的类脑学习模型、星上计算资源受限的学习理论与硬件实现技术等,实现VideoSAR运动目标的关联识别,提高动目标检测、识别与跟踪算法的稳定性。

图19 VideoSAR运动目标跟踪结果(美国Sandia实验室)

四、遥感脑(OmniEarth)

1.遥感脑

依托遥感解译研究与应用的深厚技术积累,成功研制了遥感智能解译平台——西电遥感脑(OmniEarth)。平台模拟脑神经结构和信息处理机制,在遥感影像的感知、认知、推理、决策等方面建立了系统的类脑解译理论和方法,构建了集基础算力、稀疏感知、影像解译、数据治理、场景应用于一体的智慧遥感综合解决方案,为客户提供高精准、快响应、自动化的遥感影像智能解译服务。平台可以准确地完成全色、可见光、多光谱、高光谱、合成孔径雷达影像以及遥感视频等全模态遥感数据的目标信息快速提取与识别任务,进而高效实现全方位,全链路的多源数据融合处理。

目前遥感大数据智能解译平台已开放地物要素理解、目标检测识别、要素变化检测、视频智能解译四大功能。借助“AI+遥感”的全新模式,平台可应用于城镇规划发展、智慧山川林业、国土资源监测、灾害监测评估、实时目标监控、智慧城市建设等多种场景,为遥感数据处理提供技术支撑。简洁高效的操作和智能统计分析,使得平台无需任何人工智能或遥感的专业知识背景即可操作;“云+端”协同的运行模式,缓解用户端的计算压力,大幅降低了遥感解译行业的应用门槛。西电遥感脑以“AI+遥感”的方式,推动“数字化解译”向“智能化解译”转型升级,引领中国迈入智能新时代,扎实推进共同富裕的高质量发展。

西电遥感脑——遥感智能解译平台网址:http://47.97.17.8/XdFront/index.html,或扫描如下二维码试用。

图20 西电遥感脑网址

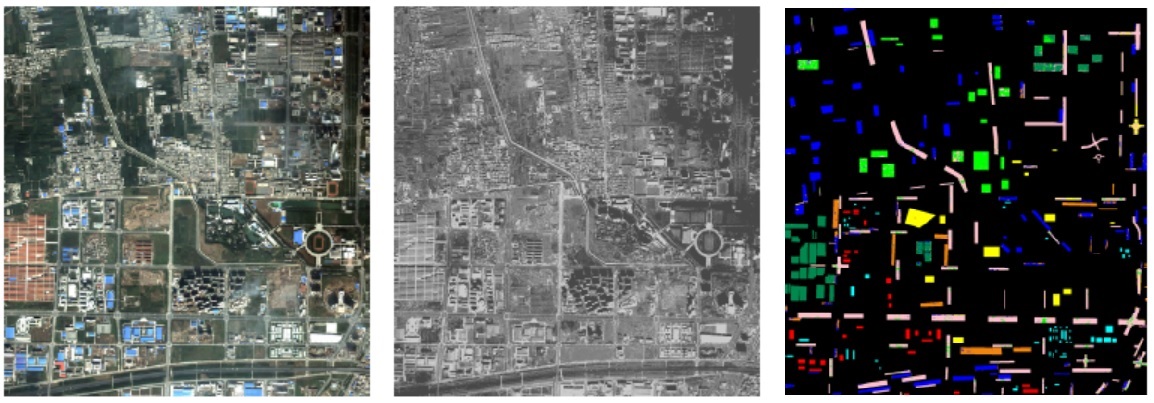

2.可见光遥感图像解译

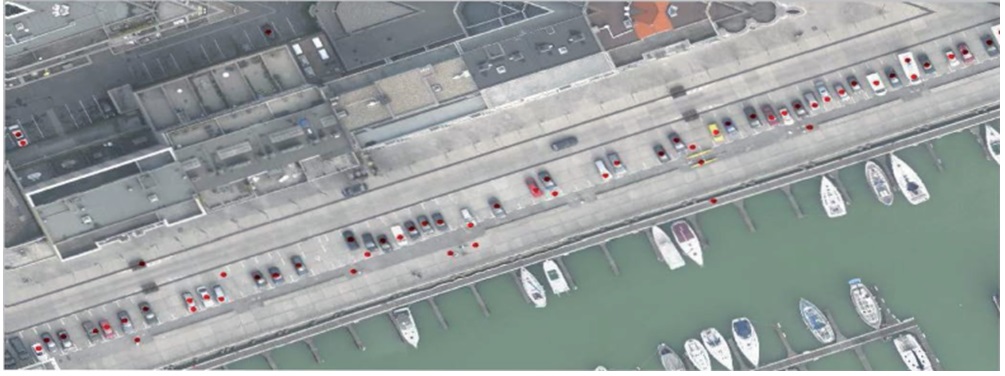

面向高分辨可见光遥感影像地物分类、目标检测、路网和水域提取、超分辨等,通过挖掘遥感影像特征,研究了遥感影像中乡村道路、城市道路和水域的自动提取,提出了城市道路提取的角度纹理特征匹配算法,乡村道路提取的多角度边界模板响应算法,以及水域边线提取的光谱特征相似度检测算法;针对传统大场景车辆检测效率低,定位误差偏大等问题,提出了光学图像和Lidar图像融合下的显著性车辆检测。针对目前已有的舰船检测在高分辨大场景下搜索速度慢,识别精度低等问题,提出了基于激光雷达和光学遥感图像融合的大场景舰船检测。针对遥感影像的数据量大、信息丰富便于利用的特点,搭建了高性能计算机集群,采用了最新的分布式高性能集群技术,建立了基于深度学习的目标检测与地物分类技术,研制了基于GPU和FPGA的遥感影像大数据类脑解译系统。

图24 光学图像和Lidar图像融合下的显著性车辆检测

图25 高分辨可见光遥感影像水系提取结果

图26 深度多示例学习的多源遥感图像分类,QuickBird 卫星图像,MS (左,2.64 m/pix),PAN (中,0.66 m/pix),和分类结果(右,OA=93.23%)

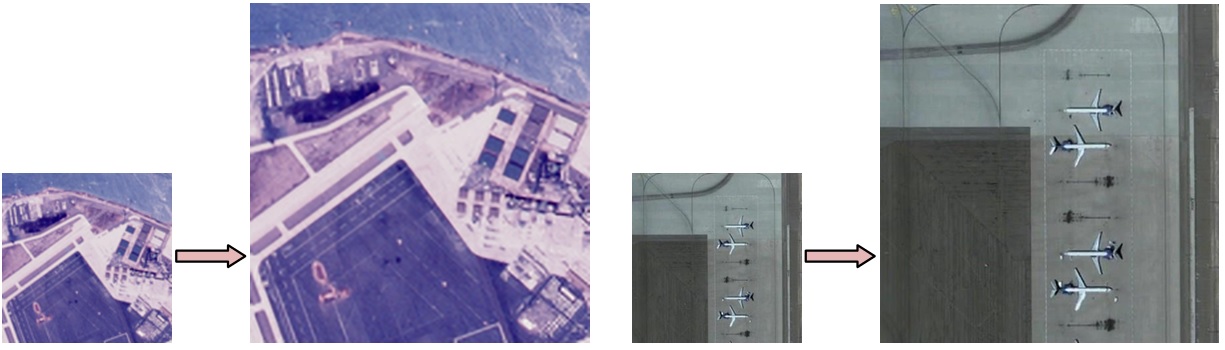

图27 基于稀疏表示和全局字典模型的自适应遥感图像超分辨

图28 基于GPU的遥感影像大数据类脑解译系统,实现了超过20层的深度CNN网络

3.红外遥感图像解译

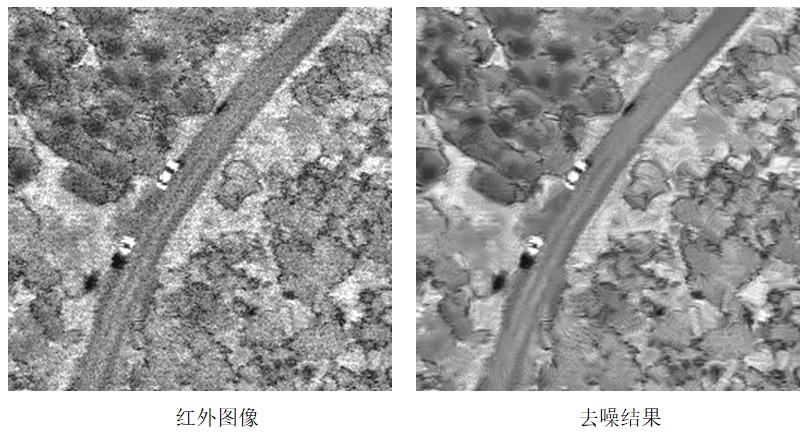

提出了基于参考辐射源与场景相结合的自适应非均匀性校正、基于边缘地物的自适应图像复原与补偿和基于直方图均衡化的自适应红外图像增强技术;针对目标的红外辐射特性和图像特征,提出了进行兴趣区检测的方法,降低背景干扰,提高目标探测概率,利用基于视觉注意机制和纹理分割实现兴趣区的检测;针对红外图像中目标的多描述特性,提出了一种基于多尺度几何分析、超完备字典稀疏编码和统计分析的红外图像目标特征提取方法;针对红外图像中目标易受噪声、遮挡的问题,提出了一种基于大规模稀疏核机器学习的快速目标识别分类方法;建立了红外图像解译系统,形成了相应的模型算法和软件组件。

图30 红外图像去噪技术

图31 基于图模型的红外图像分割技术

4.动态卫星视频解译

视频卫星通过一定时间间隔的时序图像组成视频,适于对动态目标进行分析,获得目标的速度和方向,这些重要信息从传统静态图像中难以获得。能够获取高空间分辨率对地观测动态视频,为国土资源监测、矿产资源开发、林业普查、环境保护、交通运输、防灾救灾等领域提供信息支持服务。“吉林一号”一箭四星于2015年10月7日成功发射,其中包括一颗光学遥感主星、一颗灵巧成像验证星、两颗灵巧成像视频星,开创了我国商业卫星应用领域多个第一。2017年1月9日,视频03星再次成功发射,共同组成了“吉林一号”卫星星座。2017年11月21日,我国在太原卫星发射中心用长征六号运载火箭以一箭三星方式,将吉林一号视频04、05、06星发射升空,吉林一号04、05、06星将与01、02、03星组网,为“军、政、民”三界提供了大量的数据服务。

团队针对动态卫星视频中机动目标存在外观变形、光照变化、快速运动和运动模糊、背景相似干扰等问题,以及平面外旋转、平面内旋转、尺度变化、遮挡、伪装和出视野等情况,研究了基于可变形深度卷积神经网络和均值漂移的动态卫星视频解译技术,实现了静/动态背景下的单/多目标的检测、识别、跟踪等技术,在海洋监视、环境监视、目标检测等领域有广阔的应用前景。

图32 动态卫星视频

5.遥感图像语义标注

语义标注(Image Caption)是一个集成计算机视觉、自然语言处理和机器学习的挑战性问题,是从图片中自动生成一段描述性文字,即“看图说话”,也就是让计算机不仅要能检测出图像中的物体,而且要理解物体之间的相互关系,最后还要用合理的语言表达出来,并且生成人类可读的句子(自然语言描述)。如在图像检索领域,利用生成的自然语言描述,可快速实现图像内容检索。遥感图像语义标注不仅提供场景内容描述。随着空天地各种成像传感器的发展,遥感图像理解与解译取得了显著进展,尤其是遥感图像目标检测分类与识别。但是,检测分类与识别仅仅是给出了目标属性(类型、国别等等),目标之间的关联、目标和地物之间的分布等等则无法得到。因此如何实现高效的遥感图像语义标注,成为提高遥感图像场景分析、高层语义抽取的关键难题。

团队建立了基于CNN和LSTM的遥感图像语义标注方法,该方法有效的结合了CNN在特征提取和目标检测的优点,以及LSTM在语义合成的优势。首先通过对标签数据进行训练得到一个CNN模型,对输入的遥感图像,利用该模型得到多个候选区域并提取图像特征;然后通过该模型对候选区域识别获得背景和目标类别等信息;最后将结果经过Max pooling得到图像的高层语义信息,最后输入到LSTM生成遥感图像语义描述。团队和陕西北斗金控信息服务有限公司合作,研发了基于高分1号、2号和3号等系列卫星遥感图像语义标注产品,在海量遥感图像检索和管理、大规模遥感图像分类等方面开展示范应用。

图34 遥感图像语义标注系统